最新消息

DeepSpeed 支持一键式 ChatGPT-like 模型训练,速度比最先进的 RLHF 系统快 15 倍,并在所有规模上实现了前所未有的成本降低;了解如何.

-

[2025/04] DeepCompile:解锁分布式训练的编译器优化

-

[2024/12] Ulysses-Offload:长上下文 LLM 训练的民主化

-

[2024/12] DeepSpeed Domino:免通信 LLM 训练引擎

-

[2024/08] DeepSpeed on Windows [日本語] [中文]

更多新闻

- [2024/08] DeepNVMe:通过 I/O 优化改进 DL 应用 [日本語] [中文]

- [2024/07] DeepSpeed 通用检查点:大规模分布式训练的高效灵活检查点 [日本語]

- [2024/03] DeepSpeed-FP6:FP6 中心服务对大型语言模型的强大支持 [中文]

DL 训练和推理的极致速度和规模

DeepSpeed 赋能了世界上最强大的语言模型,如 MT-530B 和 BLOOM。它是一个易于使用的深度学习优化软件套件,为训练和推理提供了前所未有的规模和速度。借助 DeepSpeed,您可以:

- 训练/推理数十亿或数万亿参数的稠密或稀疏模型

- 实现卓越的系统吞吐量并高效扩展到数千个 GPU

- 在资源受限的 GPU 系统上进行训练/推理

- 实现前所未有的低延迟和高吞吐量推理

- 实现极致压缩,以极低的成本获得无与伦比的推理延迟和模型大小减小

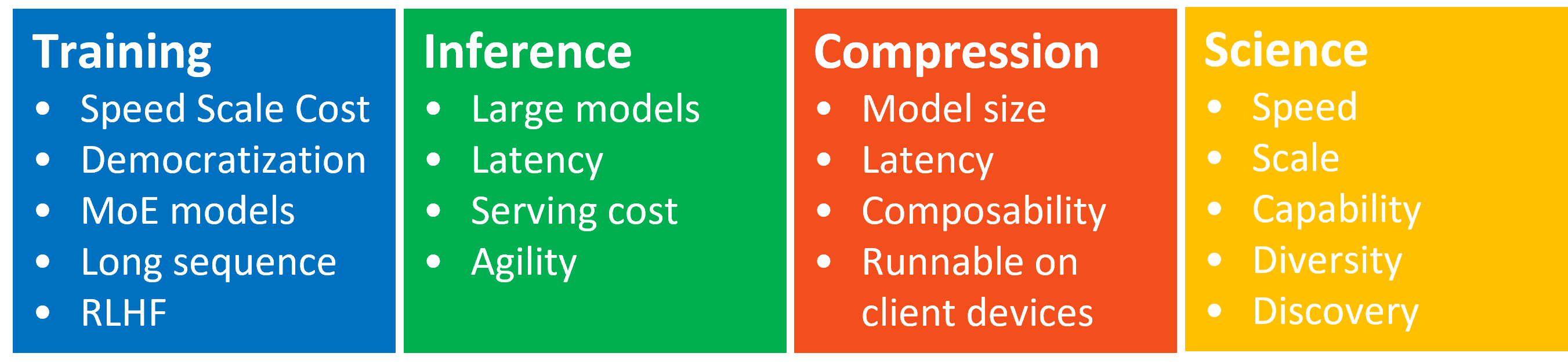

DeepSpeed 拥有四大创新支柱

DeepSpeed-Training

DeepSpeed 汇集了系统创新,使大规模深度学习训练变得高效且易于使用,并重新定义了深度学习训练在可能达到的规模方面的格局。这些创新,如 ZeRO、3D-并行、DeepSpeed-MoE、ZeRO-Infinity 等,都属于 DeepSpeed-Training 支柱。了解更多:DeepSpeed-Training

DeepSpeed-Inference

DeepSpeed 将张量、流水线、专家和 ZeRO 并行等并行技术创新结合起来,并将其与高性能自定义推理内核、通信优化和异构内存技术相结合,从而实现前所未有的规模推理,同时实现无与伦比的延迟、吞吐量和成本降低。这种系统技术在推理方面的系统组成属于 DeepSpeed-Inference。了解更多:DeepSpeed-Inference

DeepSpeed-Compression

为了进一步提高推理效率,DeepSpeed 为研究人员和实践者提供了易于使用且灵活组合的压缩技术,以压缩模型,同时提供更快的速度、更小的模型尺寸和显著降低的压缩成本。此外,ZeroQuant 和 XTC 等最先进的压缩创新也包含在 DeepSpeed-Compression 支柱下。了解更多:DeepSpeed-Compression

DeepSpeed4Science

秉承微软解决人类最紧迫挑战的使命,微软 DeepSpeed 团队正通过启动一项名为 DeepSpeed4Science 的新倡议来抓住这一机遇,旨在通过 AI 系统技术创新构建独特的能力,帮助领域专家解开当今最大的科学谜团。了解更多:DeepSpeed4Science 网站 和 教程

DeepSpeed 软件套件

DeepSpeed 库

DeepSpeed 库将 DeepSpeed 训练、推理和压缩支柱中的创新和技术实现并打包到一个易于使用、开源的存储库中。它允许在单个训练、推理或压缩管道中轻松组合多种功能。DeepSpeed 库被深度学习社区广泛采用,并已用于支持一些最强大的模型(参见 DeepSpeed 采用情况)。

推理模型实现 (MII)

推理模型实现 (MII) 是一个开源存储库,通过消除数据科学家自身应用复杂系统优化技术的需要,使低延迟、高吞吐量推理变得人人可及。MII 开箱即用,支持数千种广泛使用的 DL 模型,这些模型经过 DeepSpeed-Inference 优化,只需几行代码即可部署,同时与它们的香草开源版本相比,可显著降低延迟。

DeepSpeed on Azure

DeepSpeed 用户多种多样,可以使用不同的环境。我们建议在 Azure 上尝试 DeepSpeed,因为这是最简单易行的方法。在 Azure 上尝试 DeepSpeed 的推荐方法是通过 AzureML 配方。作业提交和数据准备脚本已在此处提供 here。有关如何在 Azure 上使用 DeepSpeed 的更多详细信息,请遵循 Azure 教程。

DeepSpeed 采用情况

DeepSpeed 已被用于训练许多不同的大规模模型。以下是我们所知的一些示例(如果您希望包含您的模型,请提交拉取请求)

- Megatron-Turing NLG (530B)

- Jurassic-1 (178B)

- BLOOM (176B)

- GLM (130B)

- YaLM (100B)

- GPT-NeoX (20B)

- AlexaTM (20B)

- Turing NLG (17B)

- METRO-LM (5.4B)

DeepSpeed 已与多个流行的开源 DL 框架集成,例如:

| 文档 | |

|---|---|

|

Transformers with DeepSpeed |

|

Accelerate with DeepSpeed |

|

Lightning with DeepSpeed |

|

MosaicML with DeepSpeed |

DeepSpeed 是 微软 AI at Scale 倡议 不可或缺的一部分,旨在实现下一代大规模 AI 能力。

贡献

DeepSpeed 欢迎您的贡献!有关格式、测试等的更多详细信息,请参阅我们的 贡献指南。

贡献者许可协议

本项目欢迎贡献和建议。大多数贡献要求您同意一份贡献者许可协议 (CLA),声明您有权并确实授予我们使用您的贡献的权利。有关详细信息,请访问 https://cla.opensource.microsoft.com。

当您提交拉取请求时,CLA 机器人将自动确定您是否需要提供 CLA,并相应地装饰 PR(例如,状态检查、评论)。只需按照机器人提供的说明操作即可。您只需在所有使用我们 CLA 的仓库中执行一次此操作。

行为准则

本项目已采纳 微软开源行为准则。有关更多信息,请参阅 行为准则常见问题 或发送邮件至 opencode@microsoft.com,提出任何其他问题或意见。

出版物

- Samyam Rajbhandari, Jeff Rasley, Olatunji Ruwase, Yuxiong He. (2019) ZeRO: 内存优化以训练万亿参数模型。arXiv:1910.02054 和 In Proceedings of the International Conference for High Performance Computing, Networking, Storage and Analysis (SC ‘20)。

- Jeff Rasley, Samyam Rajbhandari, Olatunji Ruwase, and Yuxiong He. (2020) DeepSpeed: 系统优化使训练超过 1000 亿参数的深度学习模型成为可能。In Proceedings of the 26th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining (KDD ‘20, Tutorial)。

- Minjia Zhang, Yuxiong He. (2020) 通过渐进式层丢弃加速基于 Transformer 的语言模型训练。arXiv:2010.13369 和 NeurIPS 2020。

- Jie Ren, Samyam Rajbhandari, Reza Yazdani Aminabadi, Olatunji Ruwase, Shuangyan Yang, Minjia Zhang, Dong Li, Yuxiong He. (2021) ZeRO-Offload: 普及十亿级模型训练。arXiv:2101.06840 和 USENIX ATC 2021。[论文] [幻灯片] [博客]

- Hanlin Tang, Shaoduo Gan, Ammar Ahmad Awan, Samyam Rajbhandari, Conglong Li, Xiangru Lian, Ji Liu, Ce Zhang, Yuxiong He. (2021) 1-bit Adam: 具有 Adam 收敛速度的通信高效大规模训练。arXiv:2102.02888 和 ICML 2021。

- Samyam Rajbhandari, Olatunji Ruwase, Jeff Rasley, Shaden Smith, Yuxiong He. (2021) ZeRO-Infinity: 突破 GPU 内存壁垒,实现极致规模深度学习。arXiv:2104.07857 和 SC 2021。[论文] [幻灯片] [博客]

- Conglong Li, Ammar Ahmad Awan, Hanlin Tang, Samyam Rajbhandari, Yuxiong He. (2021) 1-bit LAMB: 具有 LAMB 收敛速度的通信高效大规模大批量训练。arXiv:2104.06069 和 HiPC 2022。

- Conglong Li, Minjia Zhang, Yuxiong He. (2021) 稳定性-效率困境:研究 GPT 模型训练中的序列长度热身。arXiv:2108.06084 和 NeurIPS 2022。

- Yucheng Lu, Conglong Li, Minjia Zhang, Christopher De Sa, Yuxiong He. (2022) 通过 0/1 Adam 最大化大规模训练的通信效率。arXiv:2202.06009。

- Samyam Rajbhandari, Conglong Li, Zhewei Yao, Minjia Zhang, Reza Yazdani Aminabadi, Ammar Ahmad Awan, Jeff Rasley, Yuxiong He. (2022) DeepSpeed-MoE: 推进专家混合推理和训练,为下一代 AI 规模赋能 arXiv:2201.05596 和 ICML 2022。[pdf] [幻灯片] [博客]

- Shaden Smith, Mostofa Patwary, Brandon Norick, Patrick LeGresley, Samyam Rajbhandari, Jared Casper, Zhun Liu, Shrimai Prabhumoye, George Zerveas, Vijay Korthikanti, Elton Zhang, Rewon Child, Reza Yazdani Aminabadi, Julie Bernauer, Xia Song, Mohammad Shoeybi, Yuxiong He, Michael Houston, Saurabh Tiwary, Bryan Catanzaro. (2022) 使用 DeepSpeed 和 Megatron 训练 Megatron-Turing NLG 530B,一个大规模生成语言模型 arXiv:2201.11990。

- Xiaoxia Wu, Zhewei Yao, Minjia Zhang, Conglong Li, Yuxiong He. (2022) 预训练 Transformer 的极致压缩:简单高效。arXiv:2206.01859 和 NeurIPS 2022。

- Zhewei Yao, Reza Yazdani Aminabadi, Minjia Zhang, Xiaoxia Wu, Conglong Li, Yuxiong He. (2022) ZeroQuant: 大规模 Transformer 高效且经济的训练后量化。arXiv:2206.01861 和 NeurIPS 2022 [幻灯片] [博客]

- Reza Yazdani Aminabadi, Samyam Rajbhandari, Minjia Zhang, Ammar Ahmad Awan, Cheng Li, Du Li, Elton Zheng, Jeff Rasley, Shaden Smith, Olatunji Ruwase, Yuxiong He. (2022) DeepSpeed 推理:以空前规模实现 Transformer 模型的高效推理。arXiv:2207.00032 和 SC 2022。[论文] [幻灯片] [博客]

- Zhewei Yao, Xiaoxia Wu, Conglong Li, Connor Holmes, Minjia Zhang, Cheng Li, Yuxiong He. (2022) Random-LTD: 随机分层 Token 丢弃为大规模 Transformer 带来高效训练。arXiv:2211.11586。

- Conglong Li, Zhewei Yao, Xiaoxia Wu, Minjia Zhang, Yuxiong He. (2022) DeepSpeed 数据效率:通过高效数据采样和路由提高深度学习模型质量和训练效率。arXiv:2212.03597 ENLSP2023 Workshop at NeurIPS2023

- Xiaoxia Wu, Cheng Li, Reza Yazdani Aminabadi, Zhewei Yao, Yuxiong He. (2023) 理解 Transformer 模型的 INT4 量化:延迟加速、可组合性和失败案例。arXiv:2301.12017 和 ICML2023。

- Syed Zawad, Cheng Li, Zhewei Yao, Elton Zheng, Yuxiong He, Feng Yan. (2023) DySR: 通过算法和系统协同设计实现自适应超分辨率。ICLR:2023。

- Sheng Shen, Zhewei Yao, Chunyuan Li, Trevor Darrell, Kurt Keutzer, Yuxiong He. (2023) 使用稀疏专家混合扩展视觉-语言模型。arXiv:2303.07226 和 Finding at EMNLP2023。

- Quentin Anthony, Ammar Ahmad Awan, Jeff Rasley, Yuxiong He, Aamir Shafi, Mustafa Abduljabbar, Hari Subramoni, Dhabaleswar Panda. (2023) MCR-DL: 深度学习的混搭通信运行时 arXiv:2303.08374 并将出现在 IPDPS 2023。

- Siddharth Singh, Olatunji Ruwase, Ammar Ahmad Awan, Samyam Rajbhandari, Yuxiong He, Abhinav Bhatele. (2023) 优化专家混合训练的混合张量-专家-数据并行方法 arXiv:2303.06318 并将出现在 ICS 2023。

- Guanhua Wang, Heyang Qin, Sam Ade Jacobs, Xiaoxia Wu, Connor Holmes, Zhewei Yao, Samyam Rajbhandari, Olatunji Ruwase, Feng Yan, Lei Yang, Yuxiong He. (2023) ZeRO++: 巨型模型训练的极致高效集体通信 arXiv:2306.10209 和 ML for Sys Workshop at NeurIPS2023 [博客]

- Zhewei Yao, Xiaoxia Wu, Cheng Li, Stephen Youn, Yuxiong He. (2023) ZeroQuant-V2: 从综合研究到低秩补偿,探索 LLMs 中的训练后量化 arXiv:2303.08302 和 ENLSP2023 Workshop at NeurIPS2023 [幻灯片]

- Pareesa Ameneh Golnari, Zhewei Yao, Yuxiong He. (2023) 选择性引导:引导扩散的所有去噪步骤都重要吗?arXiv:2305.09847

- Zhewei Yao, Reza Yazdani Aminabadi, Olatunji Ruwase, Samyam Rajbhandari, Xiaoxia Wu, Ammar Ahmad Awan, Jeff Rasley, Minjia Zhang, Conglong Li, Connor Holmes, Zhongzhu Zhou, Michael Wyatt, Molly Smith, Lev Kurilenko, Heyang Qin, Masahiro Tanaka, Shuai Che, Shuaiwen Leon Song, Yuxiong He. (2023) DeepSpeed-Chat: 简单、快速且经济的 RLHF 训练,适用于所有规模的类 ChatGPT 模型 arXiv:2308.01320。

- Xiaoxia Wu, Zhewei Yao, Yuxiong He. (2023) ZeroQuant-FP: LLMs 训练后 W4A8 量化在浮点格式上的飞跃 arXiv:2307.09782 和 ENLSP2023 Workshop at NeurIPS2023 [幻灯片]

- Zhewei Yao, Xiaoxia Wu, Conglong Li, Minjia Zhang, Heyang Qin, Olatunji Ruwase, Ammar Ahmad Awan, Samyam Rajbhandari, Yuxiong He. (2023) DeepSpeed-VisualChat: 通过多模态因果注意力实现多轮多图像交错聊天 arXiv:2309.14327

- Shuaiwen Leon Song, Bonnie Kruft, Minjia Zhang, Conglong Li, Shiyang Chen, Chengming Zhang, Masahiro Tanaka, Xiaoxia Wu, Jeff Rasley, Ammar Ahmad Awan, Connor Holmes, Martin Cai, Adam Ghanem, Zhongzhu Zhou, Yuxiong He, et al. (2023) DeepSpeed4Science 倡议:通过复杂的 AI 系统技术实现大规模科学发现 arXiv:2310.04610 [博客]

- Zhewei Yao, Reza Yazdani Aminabadi, Stephen Youn, Xiaoxia Wu, Elton Zheng, Yuxiong He. (2023) ZeroQuant-HERO: 硬件增强的鲁棒优化训练后量化框架,适用于 W8A8 Transformer arXiv:2310.17723

- Sam Ade Jacobs, Masahiro Tanaka, Chengming Zhang, Minjia Zhang, Reza Yazdani Aminadabi, Shuaiwen Leon Song, Samyam Rajbhandari, Yuxiong He. (2024) 实现超长序列 Transformer 模型训练的系统优化

- Xinyu Lian, Sam Ade Jacobs, Lev Kurilenko, Masahiro Tanaka, Stas Bekman, Olatunji Ruwase, Minjia Zhang. (2024) 通用检查点:大规模分布式训练的高效灵活检查点 arXiv:2406.18820

视频

- DeepSpeed KDD 2020 教程

- 概述

- ZeRO + 大型模型训练

- 17B T-NLG 演示

- 最快 BERT 训练 + RScan 调优

- DeepSpeed 动手深度解析:第一部分,第二部分,第三部分

- 常见问题

- 微软研究院网络研讨会

- 免费注册,所有视频均可点播。

- ZeRO & 最快 BERT:提升 DeepSpeed 中深度学习训练的规模和速度.

- DeepSpeed on AzureML

- 使用 DeepSpeed 进行大型模型训练和推理 // Samyam Rajbhandari // LLMs in Prod 会议 [幻灯片]

- 社区教程